L’AI ACT: quali scenari per le PMI?

Approvato l’A.I. Act, la prima regolamentazione europea sull’Intelligenza Artificiale, con voto finale di Consiglio e Parlamento atteso per il 24 aprile (testo della proposta è disponibile qui).

Deal!#AIAct pic.twitter.com/UwNoqmEHt5

— Thierry Breton (@ThierryBreton) December 8, 2023

Post su X di Thierry Breton, commissario europeo, dell’8 dicembre 2023. La conversazione comunque procede da anni anche in altri paesi, dove si sono proposti diversi altrettanti framework di AI Etica. Rimane il fatto che molti guardano all’Europa come punto di riferimento.

Lecito chiedersi: Perché dedicare così tanta attenzione proprio a questo argomento? Innegabile l’attenzione che l’A.I. ha attirato grazie alle capacità straordinarie, e in molti casi sconcertanti, di strumenti come ChatGPT di OpenAI. Sembra che il mondo stia per cambiare, ma non è chiaro esattamente in che modo (chi dice di saperlo, a nostro avviso, mente).

In realtà, le tecnologie che collettivamente ricadono sotto l’ombrello di Intelligenza Artificiale — e più specificatamente le tecniche di Machine Learning — non sono un fenomeno di questi anni. Applicazioni quali Speech-to-Text, riconoscimento biometrico, o la generazione automatica di testo e immagini esistono da decenni. Ma è in questo momento storico che la proliferazione di strumenti (da Midjourney a ChatGPT stesso) ha assunto un carattere quasi universale, di facile accesso, e di impatto economico trasversale.

D’altro canto, negli ultimi anni si è mossa anche l’Europa. Nel 2019 venne formato il Gruppo di esperti di alto livello sull’Intelligenza Artificiale, coinvolgendo migliaia di stakeholder tra cui istituzioni finanziarie, aziende, ricercatori ed esperti, per definire le Linee guida etiche per un’AI di fiducia (Trustworthy AI). La nota principale è la seguente: l’essere umano è da porre al centro nella progettazione e implementazione di soluzioni di automazione e software. L’A.I. Act, di fatto la formalizzazione legale di questi principi, si pone l’obiettivo di garantire la massima libertà commerciale e di innovazione tecnologia senza però ledere i diritti fondamentali della persona.

Chi lavora nel settore A.I., quelle aziende software e ricercatori che ne conoscono bene le potenzialità, potrebbero pensare di trovarsi alle strette nel momento in cui intervengono niente meno che Commissione e Parlamento europei per fissare potenziali barriere alla proliferazione libera. Con questo articolo spiegheremo alcuni concetti di base dell’A.I. Act per dimostrare che il problema non si pone, anche se sarà necessario prestare maggiore attenzione d’ora in poi.

Ostacoli all’uso etico di A.I.

Partiamo da tutte le motivazioni che hanno portato al bisogno di una regolamentazione quale l’A.I. Act. Cosa vuol usare l’Intelligenza Artificiale in maniera non etica?

Gli esempi, in realtà, abbondano.

Sorveglianza senza consenso o contesto

Immaginate l’installazione di videocamere, o l’utilizzo di infrastruttura già esistente, per l’acquisizione indiscriminata di dati biometrici. Trattasi di riconoscimento del volto, o persino della camminata (che è altrettanto distintiva), consentendo con una certa percentuale di errore, l’identificazione delle persone.

A primo impatto, la cosa può far rabbrividire. Ma pensiamo ora alla necessità di impedire un attacco terroristico, o di trovare una persona rapita. Per tutti gli usi leciti potenziali ne esistono altrettanti di illeciti. Il prossimo esempio cattura bene questa ambivalenza.

Scraping di immagini senza consenso o contesto

L’azienda ClearviewAI è famosa per aver raccolto, senza consenso, miliardi di immagini da qualsiasi fonte online – piattaforma social, profili professionali, ecc. Il tutto per realizzare un’applicazione di riconoscimento facciale tra le più complete al mondo… per poi vendere il software commerciale a diversi Paesi e alle forze dell’ordine. Come nel caso precedente: il problema è la mera esistenza della tecnologia, oppure ci sono questioni ben più complesse da affrontare, quali la privacy, il consenso, e la sicurezza della persona?

Realizzazione immagini fake

Come non parlare poi dei deepfake. Gli esempi abbondano di immagini, video e testi “autogenerati” e utilizzati per dare una percezione falsata della realtà. Si parla di attacchi al Pentagono mai avvenuti, della Casa Bianca in fiamme, e della circolazione di immagini esplicite di celebrità. L’impatto può essere temporaneo (un calo dei mercati azionari) o permanente (la reputazione della persona, con conseguenze sulle opportunità di lavoro).

Queste tematiche potrebbero sembrare impossibili da gestire, e infatti ci sono molte complessità che verranno comprese solo negli anni a venire. Nonostante questo, l’A.I. Act è il tentativo, a nostro avviso, tra i più completi e previdenti al momento.

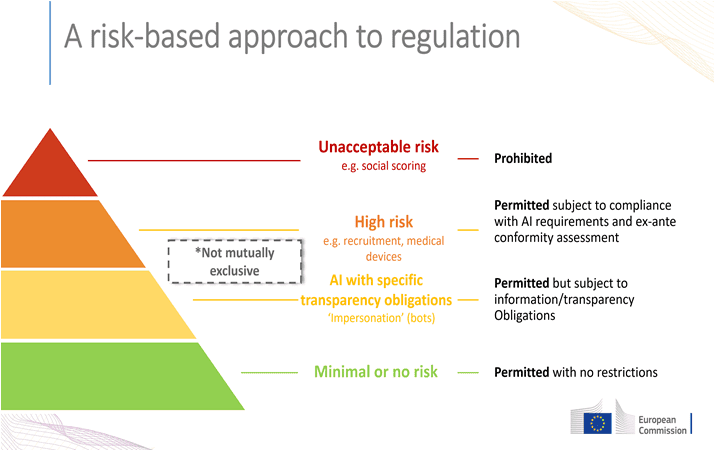

Figura 2. L’approccio dell’UE alla categorizzazione del rischio

L’approccio basato sul Grado di Rischio

Uno degli elementi fondamentali del regolamento è la suddivisione di applicativi A.I. sulla base del grado di rischio. Questo approccio è necessario, anche per far fronte all’enorme vastità di applicazioni possibili. Di interesse non è quale algoritmo di Machine Vision sia stato utilizzato per consentire a un braccio cobotico di identificare caciotte di formaggio lungo una catena di produzione agroalimentare: ciò che interessa è quanto questa applicazione possa nuocere agli operatori umani coinvolti nella linea.

Vediamo brevemente le diverse categorie (che non sono sempre mutuamente esclusive):

|

Grado di rischio |

Obblighi |

Esempi |

|

Minimo o nessun rischio |

Nessuno |

|

|

Limitato |

Trasparenza su aspetti specifici: l’utente deve sapere che sta usando un sistema basato sull’AI |

|

|

Alto |

È richiesta una valutazione e mitigazione del rischio ufficiale, tramite assessment e registrazione su un database europeo. Di fatto, si tratterà di una certificazione. |

… |

|

Non accettabile |

L’applicazione è illegale. |

|

Alcuni divieti chiave derivanti dall’AI Act

Notiamo qui alcuni divieti a cui prestare particolare attenzione, ricollegandoci anche agli esempi di prima per rassicurarci che la società non diventi una distopia da fantascienza.

Sfruttamento dati gruppi vulnerabili

È vietato sfruttare dati sensibili come credenze politiche/religiose o tratti etnici per distorcere il comportamento di una persona in modo tale da provocare danni a quella o ad altre persone. Lo scopo di questo divieto è di impedire alle piattaforme di effettuare discriminazioni nei confronti dei propri utenti, ad esempio aumentando i prezzi di un prodotto per uno specifico gruppo etnico.

Scraping indiscriminato

È vietato raccogliere immagini di volti da internet o da telecamere a circuito chiuso in maniera indiscriminata. È possibile raccogliere immagini di volti solo se con il consenso del diretto interessato e se l’operazione di raccolta ha una finalità legittima (es. ricerca vittime di un crimine, ricerca minori, ecc.). Ogni utilizzo richiederà l’autorizzazione di un’autorità giudiziaria (o altro ente autorizzato, ancora da determinare).

Questo divieto rinforza la posizione dell’Unione Europea riguardo alla Protezione dei Dati Personali, impedendo l’utilizzo sistematico di dati sensibili ed identificanti.

Tecniche di influenza subliminale

È vietato utilizzare sistemi che influenzano in maniera inconscia il comportamento dell’utente in modo tale da aumentare il rischio di danni psicologici o fisici. Lo scopo di questo divieto è quello di garantire il diritto alla dignità di ogni cittadino, anche definibile come diritto alla riservatezza.

Social scoring

È altresì vietato per un ente pubblico utilizzare le intelligenze artificiali per assegnare un “punteggio sociale” ai cittadini, tramite l’analisi dei comportamenti, le interazioni online, ecc. se ciò può comportare trattamenti sfavorevoli o dannosi.

Cosa aspettarsi ora

La maggior parte degli obblighi si gioca sulle applicazioni ad alto rischio. In effetti, questo approccio non si discosta da quello attuale di certificazione UE per macchinari e applicativi quando la situazione lo richiede. Il grande vantaggio dell’A.I. Act, infatti, è la sua integrazione con framework legali già esistenti, seguendo le stesse forme e soprattutto la stessa ottica di tutela della persona.

Man mano che si organizzano i diversi punti di riferimento – il registro delle applicazioni High Risk, gli enti autorizzati, ecc. – ci aspettiamo un futuro per l’A.I. tanto dirompente quanto lo è ora, ma con le dovute precauzioni in più per assicurarci che le soluzioni che sviluppiamo siano di beneficio, prima di tutto, alle persone – chi acquista e utilizza la soluzione – e poi a chi ne sviluppa l’infrastruttura.